인공지능을 결정하는 3가지 기술요소는 알고리즘, 컴퓨팅 파워, 그리고 데이터다.

알고리즘이란 기계를 학습시키는 소프트웨어, 즉 머신러닝 알고리즘이다. 2000년대에 들어 딥러닝이 급속도로 발전한 배경에는 바로 혁신적인 딥러닝 알고리즘의 등장이 있었다.

◇인공지능 경쟁력의 3요소는...알고리즘, 컴퓨팅 파워, 데이터

그런데 최근 이 학습 알고리즘은 인터넷을 통해 쉽게 구할 수 있게 되었다. 지금 머신러닝 업계에서 전례 없는 오픈소스 공개의 장이 펼쳐지고 있기 때문이다. 구글은 세계 최고 수준의 딥러닝 엔진인 텐서플로(TensorFlow)를 공개했고 그 외에 빅DL(BigDL),오픈딥(OpenDeep), 카페(Caffe), 씨아노(Theano), 토치(Torch), 엠엑스넷(MXNet) 등 수많은 툴이 공개되면서, 공급 과잉의 상태다.

이제 분석가는 고도한 딥러닝 소프트웨어를 손수 개발할 필요가 없이, 이미 공개된 머신러닝 소프트웨어를 이용해 누구나 손쉽게 인공지능 서비스를 만들 수 있다.

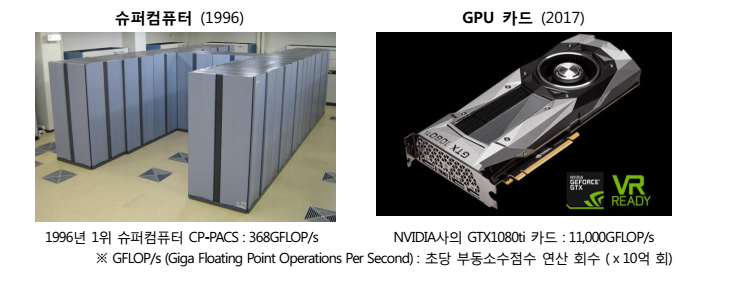

컴퓨팅 파워 역시 딥러닝 또는 머신러닝에 필수 불가결한 요소이다. 특히 깊은 층으로 구성된 신경망을 학습하기 위해서는 높은 성능의 하드웨어가 필요하다. 현재 컴퓨터 성능의 발전은 지수형 그래프로 그 속도계 계속 빨라지고 있다.

세계에서 가장 빨랐던 슈퍼컴퓨터도 6~8년 후 500위 리스트에서 탈락하게 되고, 8~10년이 더 지나면 일반 노트북 수준의 성능이 된다.

이처럼 빠르게 발전하는 컴퓨터 성능의 발전은 복잡하고 많은 양의 계산이 필요한 딥러닝이 자리잡는 데 많은 공헌을 했다.

컴퓨터 그래픽 처리용으로 개발되었던 GPU 카드를 숫자 연산기로 탈바꿈시키는 GPGPU4 기술이 나오면서 딥러닝의 여건이 더욱 나아졌다. GPU는 구조가 단순하여 패키지 하나에 최대 4천 여개의 코어로 구성된다. 아무리 비싼 CPU도 10~20개 코어 수준인 점에 비추어 볼 때 GPU의 병렬 처리 수준이 비교가 안될 정도로 우수하다.

◇엔비디아 최신 GPU하나가 2010년 수퍼컴퓨터 성능 넘어서

GPU에 이렇게 많은 코어를 담을 수 있는 이유는 CPU에 포함된 다양하고 복잡하고 기능의 연산회로가 빠져있기 때문이다. 딥러닝에서의 퍼셉트론 연산은 아주 간단한 행렬 연산의 반복으로만 이루어지므로 GPU로도 계산이 가능하고, 그래서 GPU사용이 딥러닝의 표준이 되었다.

2012년 구글 브레인 프로젝트에서 3일동안 이미지 1천 만 개를 학습시키는데 16,000개의 컴퓨터를 이용했는데, 1년뒤 바이두의 인공지능 연구소에서는 동일한 성능을 단 3대의 컴퓨터만으로 구현했다.GPU기술 덕분이다.

올초 출시된 NVIDIA사의 GTX1080ti 카드 1장의 성능은 2001년 세계 1위의 슈퍼컴퓨터 성능을 넘어섰고, 1996년 세계 최고 슈퍼컴퓨터였던 CP-PACS 성능의 30배 수준에 달한다. 이처럼 GPGPU의 발전은 딥러닝 분야에서 컴퓨팅 파워의 성능 및 비용적 제약을 상당부분 해소했다.

◇인공지능의 핵심 경쟁력은 ‘빅데이터’

KT경제경영연구소의 류성일 연구원은 "인공지능 선진 기업들이 앞다투어 머신러닝 알고리즘을 공개하고 있는 까닭은 무엇일까? 역설적이게도 알고리즘은 더 이상 인공지능 핵심 경쟁력이 아니라고 판단하기 때문"이라며 "학습 알고리즘 보다 더 중요한 요소는 바로 데이터"라고 지적한다.

데이터는 머신러닝이 학습하는 재료이다. 최근 딥러닝이 급격히 발전한 까닭은 바로 인공지능이 학습할 재료가 풍부해졌다는데 있다. 디지털 카메라와 스마트폰 사진 촬영이 대중화되면서 분석 가능한 디지털 사진이 폭발적으로 증가했다.

사진 공유 기반 SNS인 스냅챗(Snapchat)의 경우 1분마다 28만 장 이상의 사진이 전달되고 있고, 유튜브에는 1분마다 300시간 분량의 새로운 동영상이 추가로 업로드되고 있다.

데이터의 폭발적 증가는 사진뿐만이 아니다. 오늘날 매일 생산되는 디지털 데이터의 규모는 8ZB(제타바이트)에 달한다. 8ZB는 80억 TB(테라바이트)에 달하는 양이다.

데이터의 규모와 다양성이 확대되면서 점차 단순 통계/집계를 넘어 BI 및 CRM을 위한 분석, 그리고 최근에는

예측/판단 등 지능화 서비스를 위한 분석까지 이르렀다. 빅데이터의 용도가 인공지능 분야로 진화한 것이다

류연구원은 "앞으로의 인공지능 경쟁력은 결국 데이터에서 창출될 것이다. 딥러닝에서는 데이터의 양과 질이 모두 중요하다. 사진을 인식하고 무언가를 예측하고자 한다면 정답이 적혀있는 엄청난 양의 빅데이터 확보가 필연적"이라고 내다봤다.

예컨대 사진으로부터 개와 고양이를 인식하고자 한다면 수많은 사진 데이터와 함께 그 사진에 개가 있는지 고양이가 있는지를 라벨링을 해야 한다. 그래야 기계가 학습을 할 수 있다. SNS에 ‘개’, ‘고양이’라는 텍스트와 함께 올린 사진 데이터가 그러한 조건에 부합하는 데이터일 것이다.

이런 광범위한 빅데이터를 가진 회사는 구글, 페이스북, 바이두 등의 전통적 인터넷/모바일 대기업들이다. 국내에서는 네이버가 확실히 유리한 위치에 서 있다.

알고리즘의 가치보다 빅데이터의 가치가 훨씬 더 크다. 목적에 따라 정확히 라벨링 된 데이터를 얻기 위해서는 많은 시간과 비용이 소요되기 때문이다. 결국 양질의 데이터를 누가 많이 가지고 있는지에 따라 머신러닝의 품질이 달라지게 되고, 향후 인공지능의 미래를 이끄는 리더가 될 것이다.

자료협조 ; KT경제경영연구소

한익재 기자 gogreen@greened.kr